문제12) 적대적 공격(Adversarial Attack)

답)

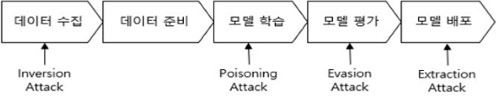

1. 머신 러닝 알고리즘 취약점, AI 적대적 공격의 개요

|

||

|

2. AI 적대적 공격의 유형 및 사례

가. AI 적대적 공격의 유형

|

구분

|

공격 기법

|

설명

|

|

직접적 공격

|

Poisoning

|

|

|

Evasion

|

|

|

|

간접적 공격

|

Inversion

|

|

|

Extraction

|

|

|

|

특정 결과

|

Target

|

|

|

Non-target

|

|

|

|

기존 정보

보유 여부 |

Black box

|

|

|

White box

|

|

|

|

||

나. AI 적대적 공격 사례

|

구분

|

유형

|

설명

|

|

자동차

|

오인식

|

|

|

표지판 변형

|

|

|

|

의료

|

보험 사기

|

|

|

임상 실험

|

|

|

|

역이용

|

모델 평가

|

|

|

일반화 검증

|

|

|

|

||

3. AI 적대적 공격 방어 기법

|

방어 기법

|

설명

|

|

Adversarial Training

|

|

|

Gradient Masking

|

|

|

Distillation

|

|

|

Defense GAN

|

|

공감과 댓글은 아이티신비에게 큰 힘이 됩니다.

블로그 글이 유용하다면 블로그를 구독해주세요.♥